DeepSeek AI 可用平台(完整版整理)

我已将 1~17 全部整理到一个表格,并优化描述,方便快速筛选合适的访问方式。

DeepSeek AI 访问方式总览

|

序号 |

平台名称 |

网址 |

说明 |

|---|---|---|---|

|

推荐 |

|||

|

1 |

秘塔搜索 |

深度搜索 AI 平台,集成 DeepSeek-R1,适合信息查询。使用次数100 |

|

|

2 |

360纳米AI搜索 |

app store搜索“纳米AI搜索” |

360 旗下 AI 搜索引擎,结合 DeepSeek-R1 提供智能问答。主要在app中体验,侧重大陆地区 |

|

✅ 可用(普通访问方式) |

|||

|

3 |

硅基流动 |

云端 AI 平台,支持 DeepSeek-R1,对话记录不保存。侧重api |

|

|

4 |

字节跳动火山引擎 |

火山引擎 AI 体验平台,可免费试用 DeepSeek-R1。 |

|

|

5 |

百度云千帆 |

百度 AI 云服务,支持 DeepSeek-R1 API 访问。 |

|

|

6 |

英伟达 NIM |

英伟达 NIM 平台,提供 DeepSeek-R1 API 访问。 |

|

|

7 |

Groq |

基于 Llama 70B 蒸馏版,推理速度极快,但中文能力较弱。 |

|

|

8 |

Fireworks |

提供 DeepSeek-R1 API 访问,适合开发者调用。 |

|

|

9 |

Chutes |

轻量级 AI 平台,可直接使用 DeepSeek-R1 进行交互。 |

|

|

10 |

阿里云百炼 |

阿里云提供的 DeepSeek-R1 交互环境,支持 API 调用。 |

|

|

🚧 需要魔法(受限或暂时不可用) |

|||

|

11 |

GitHub |

需要魔法,DeepSeek-R1 在 GitHub Marketplace 上暂无开放使用。 |

|

|

12 |

POE |

需要魔法,POE 目前无法访问 DeepSeek-R1。免费额度很有限 |

|

|

13 |

Cursor |

需要魔法,支持 DeepSeek-R1,但是需要会员才能使用。 |

|

|

14 |

Monica |

需要魔法, |

|

|

15 |

Lambda |

需要魔法, |

|

|

16 |

Cerebras |

需要魔法, |

|

|

17 |

Perplexity |

需要魔法,Perplexity AI 支持 DeepSeek-R1。 |

本地运行

需要测试电脑配置适合的版本

| 产品 | 界面 | 控制 | |

| 1 | https://ollama.com/ | 无界面 | |

| 2 | https://www.nomic.ai/gpt4all | 有 | 可控 |

| 3 | https://lmstudio.ai/ | 有 | 太可控和调节了 |

DeepSeek-R1 模型硬件需求整理表

|

模型版本 |

CPU |

内存 |

硬盘 |

显卡 |

场景 |

|---|---|---|---|---|---|

|

DeepSeek-R1-1.5B |

最低 4 核(推荐 Intel/AMD 多核处理器) |

8GB+ |

3GB+(模型文件约 1.5-2GB) |

非必需(纯 CPU 推理),若 GPU 加速可选 4GB+ 显存(如 GTX 1650) |

低资源设备部署(如树莓派、旧款笔记本);实时文本生成(聊天机器人、简单问答);嵌入式系统或物联网设备 |

|

DeepSeek-R1-7B |

8 核以上(推荐现代多核 CPU) |

16GB+ |

8GB+(模型文件约 4-5GB) |

推荐 8GB+ 显存(如 RTX 3070/4060) |

本地开发测试(中小型企业);中等复杂度 NLP 任务(文本摘要、翻译);轻量级多轮对话系统 |

|

DeepSeek-R1-8B |

硬件需求与 7B 相近,略高 10-20% |

需更高精度的轻量级任务(如代码生成、逻辑推理) |

|||

|

DeepSeek-R1-14B |

12 核以上 |

32GB+ |

15GB+ |

16GB+ 显存(如 RTX 4090 或 A5000) |

企业级复杂任务(合同分析、报告生成);长文本理解与生成(书籍/论文辅助写作) |

|

DeepSeek-R1-32B |

16 核以上(如 AMD Ryzen 9 或 Intel i9) |

64GB+ |

30GB+ |

24GB+ 显存(如 A100 40GB 或双卡 RTX 3090) |

高精度专业领域任务(医疗/法律咨询);多模态任务预处理(需结合其他框架) |

|

DeepSeek-R1-70B |

32 核以上(服务器级 CPU) |

128GB+ |

70GB+ |

多卡并行(如 2x A100 80GB 或 4x RTX 4090) |

科研机构/大型企业(金融预测、大规模数据分析);高复杂度生成任务(创意写作、算法设计) |

|

DeepSeek-R1-671B |

64 核以上(服务器集群) |

512GB+ |

300GB+ |

多节点分布式训练(如 8x A100/H100) |

国家级/超大规模 AI 研究(如气候建模、基因组分析);通用人工智能(AGI)探索 |

通用建议

•量化优化:使用 4-bit/8-bit 量化可降低显存占用 30-50%。

•推理框架:搭配 vLLM、TensorRT 等加速库提升效率。

•云部署:70B/671B 建议优先考虑云服务以弹性扩展资源。

•能耗注意:32B+ 模型需高功率电源(1000W+)和散热系统。

这个表格清晰列出了不同版本的 DeepSeek-R1 模型所需的硬件配置及应用场景,您可以根据具体需求进行选择。如果有任何需要调整或进一步优化的地方,请随时告诉我!😊

大礼包

应用程序

|

Chatbox | 一个支持多种流行LLM模型的桌面客户端,可在 Windows、Mac 和 Linux 上使用 |

|

ChatGPT-Next-Web | 一键获取跨平台ChatGPT网页用户界面,支持流行的LLM |

|

留白记事 | 留白让你直接在微信上使用 DeepSeek 管理你的笔记、任务、日程和待办清单! |

|

Pal – AI Chat Client (iOS, ipadOS) |

一款可以在 iPhone 或 iPad 上使用的 AI 助手 |

| LibreChat | LibreChat 是一个可定制的开源应用程序,无缝集成了 DeepSeek,以增强人工智能交互体验 | |

| PapersGPT | PapersGPT是一款集成了DeepSeek及其他多种AI模型的辅助论文阅读的Zotero插件. | |

| RSS翻译器 | 开源、简洁、可自部署的RSS翻译器 | |

|

Enconvo | Enconvo是AI时代的启动器,是所有AI功能的入口,也是一位体贴的智能助理. |

|

Cherry Studio | 一款为创造者而生的桌面版 AI 助手 |

|

ToMemo (iOS, ipadOS) | 一款短语合集 + 剪切板历史 + 键盘输出的iOS应用,集成了AI大模型,可以在键盘中快速输出使用。 |

| Video Subtitle Master | 批量为视频生成字幕,并可将字幕翻译成其它语言。这是一个客户端工具, 跨平台支持 mac 和 windows 系统, 支持百度,火山,deeplx, openai, deepseek, ollama 等多个翻译服务 | |

| Easydict | Easydict 是一个简洁易用的词典翻译 macOS App,能够轻松优雅地查找单词或翻译文本,支持调用大语言模型 API 翻译。 | |

| Raycast | Raycast 是一款 macOS 生产力工具,它允许你用几个按键来控制你的工具。它支持各种扩展,包括 DeepSeek AI。 | |

| Nice Prompt | Nice Prompt 是一个结合提示工程与社交功能的平台,支持用户高效创建、分享和协作开发AI提示词。 | |

| Zotero | Zotero 是一款免费且易于使用的文献管理工具,旨在帮助您收集、整理、注释、引用和分享研究成果。 | |

|

思源笔记 | 思源笔记是一款隐私优先的个人知识管理系统,支持完全离线使用,并提供端到端加密的数据同步功能。 |

| go-stock | go-stock 是一个由 Wails 使用 NativeUI 构建并由 LLM 提供支持的股票数据查看分析器。 | |

| Wordware | Wordware 这是一个工具包,使任何人都可以仅通过自然语言构建、迭代和部署他们的AI堆栈 | |

|

Dify | Dify 是一个支持 DeepSeek 模型的 LLM 应用开发平台,可用于创建 AI 助手、工作流、文本生成器等应用。 |

| LiberSonora | LiberSonora,寓意”自由的声音”,是一个 AI 赋能的、强大的、开源有声书工具集,包含智能字幕提取、AI标题生成、多语言翻译等功能,支持 GPU 加速、批量离线处理 | |

| Bob | Bob 是一款 macOS 平台的翻译和 OCR 软件,您可以在任何应用程序中使用 Bob 进行翻译和 OCR,即用即走! | |

| STranslate | STranslate(Windows) 是 WPF 开发的一款即用即走的翻译、OCR工具 | |

|

GPT AI Flow | 工程师为效率狂人(他们自己)打造的终极生产力武器: GPT AI Flow

|

|

Story-Flicks | 通过一句话即可快速生成高清故事短视频,支持 DeepSeek 等模型。 |

AI Agent 框架

| Anda | 一个专为 AI 智能体开发设计的 Rust 语言框架,致力于构建高度可组合、自主运行且具备永久记忆能力的 AI 智能体网络。 | |

|

Alice | 一个基于 ICP 的自主 AI 代理,利用 DeepSeek 等大型语言模型进行链上决策。Alice 结合实时数据分析和独特的个性,管理代币、挖掘 BOB 并参与生态系统治理。 |

RAG 框架

| RAGFlow | 一款基于深度文档理解构建的开源 RAG(Retrieval-Augmented Generation)引擎。RAGFlow 可以为各种规模的企业及个人提供一套精简的 RAG 工作流程,结合大语言模型(LLM)针对用户各类不同的复杂格式数据提供可靠的问答以及有理有据的引用。 |

即时通讯插件

|

茴香豆 (个人微信/飞书) |

一个集成到个人微信群/飞书群的领域知识助手,专注解答问题不闲聊 |

|

LangBot (QQ, 企微, 飞书) |

大模型原生即时通信机器人平台,适配 QQ / QQ频道 / 飞书 / OneBot / 企业微信(wecom) 等多种消息平台 |

浏览器插件

|

沉浸式翻译 | 一款双语对照网页翻译插件,简洁,高效 |

| 沉浸式导读 | NO Sidebar!!! 沉浸式的 AI 网页摘要,提问… | |

|

ChatGPT Box | 将 LLM 作为私人助手,整合到你的浏览器中 |

|

划词翻译 | 整合了多家翻译 API 以及 LLM API 的浏览器翻译插件 |

|

欧路翻译 | 提供鼠标划词搜索、逐段对照翻译、PDF文献翻译功能。可以使用支持 DeepSeek AI, Bing、GPT、Google等多种翻译引擎。 |

| 流畅阅读 | 一款革新性的浏览器开源翻译插件,让所有人都能够拥有基于母语般的阅读体验 | |

| 馆长 | 知识库AI问答助手 – 让AI帮助你整理与分析知识 |

VS Code 插件

|

Continue | 开源 IDE 插件,使用 LLM 做你的编程助手 |

| Cline | Cline 是一款能够使用您的 CLI 和编辑器的 AI 助手。 |

neovim 插件

|

avante.nvim | 开源 IDE 插件,使用 LLM 做你的编程助手 |

|

llm.nvim | 免费的大语言模型插件,让你在Neovim中与大模型交互,支持任意一款大模型,比如Deepseek,GPT,GLM,kimi或者本地运行的大模型(比如ollama) |

|

codecompanion.nvim | AI 驱动的编码,在 Neovim 中无缝集成. |

JetBrains 插件

| Chinese-English Translate | 集成了多家国内翻译和ai厂商,将中文翻译到英文的插件。 | |

| AI Git Commit | 使用AI生成git commit message的插件。 |

其它

|

ShellOracle | 一种用于智能 shell 命令生成的终端工具。 |

|

深度求索(快捷指令) | 使用 DeepSeek API 增强Siri能力的快捷指令 |

|

n8n-nodes-deepseek | 一个 N8N 的社区节点,支持直接使用 DeepSeek API 集成到工作流中 |

|

promptfoo | 测试和评估LLM提示,包括DeepSeek模型。比较不同的LLM提供商,捕获回归,并评估响应。 |

| CR | deepseek-review | 🚀 使用 Deepseek 进行代码审核,支持 GitHub Action 和本地 🚀 |

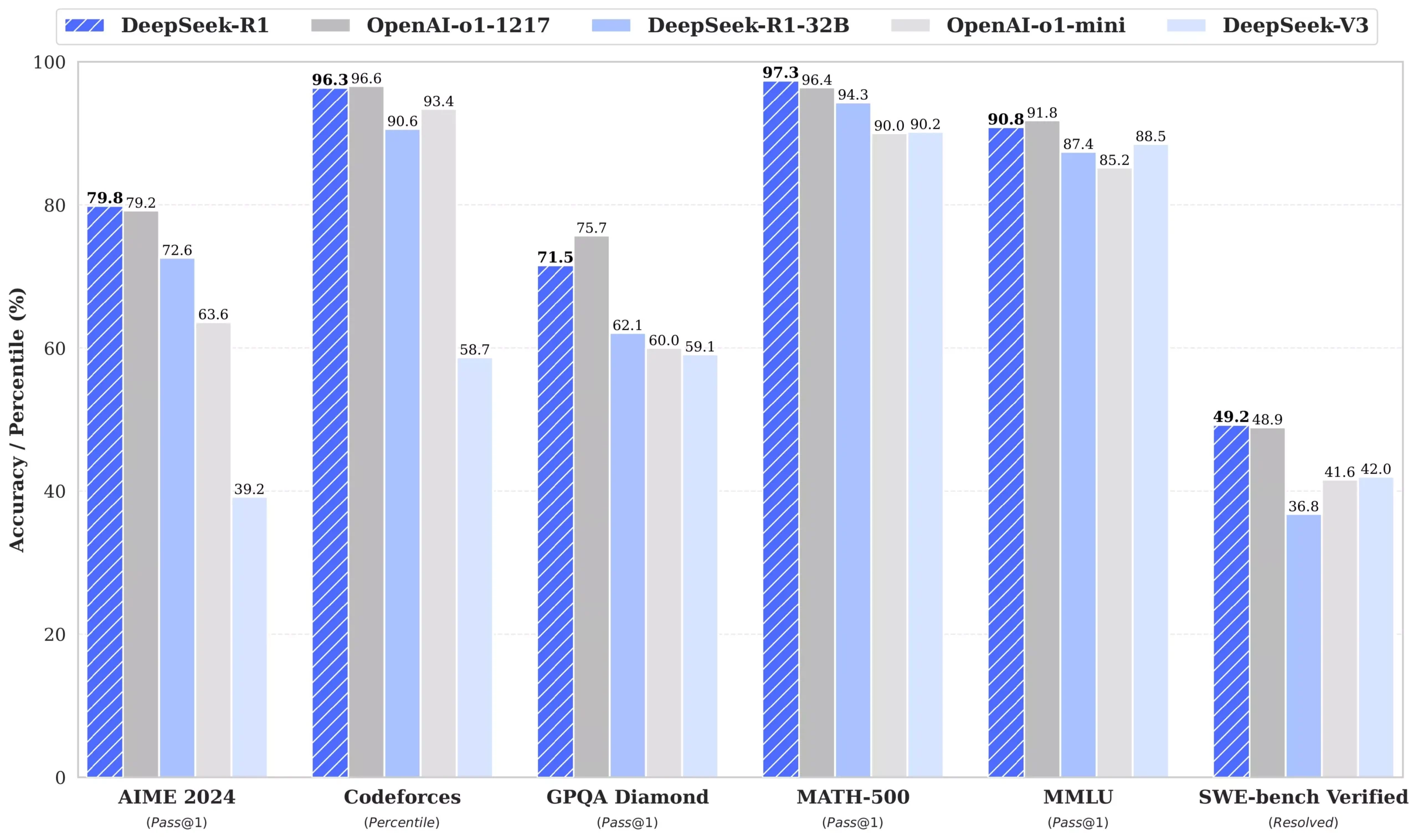

一张图,传递了所有的信息,开源与闭源之战!

1、本地部署,我们可以通过Ollama来进行安装

Ollama 官方版:【点击前往】

Web UI 控制端【点击安装】

安装命令

1.5B Qwen DeepSeek R1

ollama run deepseek-r1:1.5b

7B Qwen DeepSeek R1

ollama run deepseek-r1:7b

8B Llama DeepSeek R1

ollama run deepseek-r1:8b

14B Qwen DeepSeek R1

ollama run deepseek-r1:14b

32B Qwen DeepSeek R1

ollama run deepseek-r1:32b

70B Llama DeepSeek R1

ollama run deepseek-r1:70b

2. 更多模型下载

DeepSeek-R1

| 模型 | #总参数 | #已激活参数 | 上下文长度 | 下载 |

|---|---|---|---|---|

| DeepSeek-R1-Zero | 671B | 37B | 128千 | 🤗 HuggingFace |

| DeepSeek-R1 | 671B | 37B | 128千 | 🤗 HuggingFace |

DeepSeek-R1-Zero 和 DeepSeek-R1 基于 DeepSeek-V3-Base 进行训练。有关模型架构的更多详细信息,请参阅DeepSeek-V3存储库。

DeepSeek-R1-Distill 模型

| 模型 | 基础模型 | 下载 |

|---|---|---|

| DeepSeek-R1-Distill-Qwen-1.5B | Qwen2.5-Math-1.5B | 🤗 HuggingFace |

| DeepSeek-R1-Distill-Qwen-7B | Qwen2.5-Math-7B | 🤗 HuggingFace |

| DeepSeek-R1-Distill-Llama-8B | Llama-3.1-8B | 🤗 HuggingFace |

| DeepSeek-R1-Distill-Qwen-14B | Qwen2.5-14B | 🤗 HuggingFace |

| DeepSeek-R1-Distill-Qwen-32B | Qwen2.5-32B | 🤗 HuggingFace |

| DeepSeek-R1-Distill-Llama-70B | Llama-3.3-70B-Instruct | 🤗 HuggingFace |

DeepSeek-R1-Distill 模型基于开源模型进行了微调,使用了 DeepSeek-R1 生成的样本。我们对其配置和分词器进行了轻微更改。请使用我们的设置来运行这些模型。

4.评估结果

DeepSeek-R1-评估

对于我们所有的模型,最大生成长度设置为 32,768 个 token。对于需要采样的基准,我们使用的温度为0.6,top-p 值为0.95,并为每个查询生成 64 个响应来估计 pass@1。

| 类别 | 基准(公制) | 克劳德-3.5-十四行诗-1022 | GPT-4o 0513 | DeepSeek V3 | OpenAI o1-mini | OpenAI o1-1217 | DeepSeek R1 |

|---|---|---|---|---|---|---|---|

| 建筑学 | – | – | 教育部 | – | – | 教育部 | |

| # 激活参数 | – | – | 37B | – | – | 37B | |

| # 总参数 | – | – | 671B | – | – | 671B | |

| 英语 | MMLU(通过@1) | 88.3 | 87.2 | 88.5 | 85.2 | 91.8 | 90.8 |

| MMLU-Redux(EM) | 88.9 | 88.0 | 89.1 | 86.7 | – | 92.9 | |

| MMLU-Pro(EM) | 78.0 | 72.6 | 75.9 | 80.3 | – | 84.0 | |

| 掉落 (3 发 F1) | 88.3 | 83.7 | 91.6 | 83.9 | 90.2 | 92.2 | |

| IF-Eval(提示严格) | 86.5 | 84.3 | 86.1 | 84.8 | – | 83.3 | |

| GPQA-钻石级 (Pass@1) | 65.0 | 49.9 | 59.1 | 60.0 | 75.7 | 71.5 | |

| SimpleQA(正确) | 28.4 | 38.2 | 24.9 | 7.0 | 47.0 | 30.1 | |

| 框架(配件) | 72.5 | 80.5 | 73.3 | 76.9 | – | 82.5 | |

| AlpacaEval2.0 (LC-胜率) | 52.0 | 51.1 | 70.0 | 57.8 | – | 87.6 | |

| ArenaHard(GPT-4-1106) | 85.2 | 80.4 | 85.5 | 92.0 | – | 92.3 | |

| 代码 | LiveCodeBench (Pass@1-COT) | 33.8 | 34.2 | – | 53.8 | 63.4 | 65.9 |

| Codeforces(百分位数) | 20.3 | 23.6 | 58.7 | 93.4 | 96.6 | 96.3 | |

| Codeforces(评级) | 717 | 759 | 1134 | 1820 | 2061 | 2029 | |

| SWE 已验证(已解决) | 50.8 | 38.8 | 42.0 | 41.6 | 48.9 | 49.2 | |

| Aider-Polyglot (Acc.) | 45.3 | 16.0 | 49.6 | 32.9 | 61.7 | 53.3 | |

| 数学 | AIME 2024(通行证@1) | 16.0 | 9.3 | 39.2 | 63.6 | 79.2 | 79.8 |

| 数学-500 (通过@1) | 78.3 | 74.6 | 90.2 | 90.0 | 96.4 | 97.3 | |

| CNMO 2024 (通行证@1) | 13.1 | 10.8 | 43.2 | 67.6 | – | 78.8 | |

| 中文 | CLUEWSC(EM) | 85.4 | 87.9 | 90.9 | 89.9 | – | 92.8 |

| C-评估(EM) | 76.7 | 76.0 | 86.5 | 68.9 | – | 91.8 | |

| C-SimpleQA(正确) | 55.4 | 58.7 | 68.0 | 40.3 | – | 63.7 |

蒸馏模型评估

| 模型 | AIME 2024 通行证@1 | AIME 2024 缺点@64 | MATH-500 通过@1 | GPQA 钻石通行证@1 | LiveCodeBench 通行证@1 | CodeForces 评级 |

|---|---|---|---|---|---|---|

| GPT-4o-0513 | 9.3 | 13.4 | 74.6 | 49.9 | 32.9 | 759 |

| 克劳德-3.5-十四行诗-1022 | 16.0 | 26.7 | 78.3 | 65.0 | 38.9 | 717 |

| o1-迷你 | 63.6 | 80.0 | 90.0 | 60.0 | 53.8 | 1820 |

| QwQ-32B-预览 | 44.0 | 60.0 | 90.6 | 54.5 | 41.9 | 1316 |

| DeepSeek-R1-Distill-Qwen-1.5B | 28.9 | 52.7 | 83.9 | 33.8 | 16.9 | 954 |

| DeepSeek-R1-Distill-Qwen-7B | 55.5 | 83.3 | 92.8 | 49.1 | 37.6 | 1189 |

| DeepSeek-R1-Distill-Qwen-14B | 69.7 | 80.0 | 93.9 | 59.1 | 53.1 | 1481 |

| DeepSeek-R1-Distill-Qwen-32B | 72.6 | 83.3 | 94.3 | 62.1 | 57.2 | 1691 |

| DeepSeek-R1-Distill-Llama-8B | 50.4 | 80.0 | 89.1 | 49.0 | 39.6 | 1205 |

| DeepSeek-R1-Distill-Llama-70B | 70.0 | 86.7 | 94.5 | 65.2 | 57.5 | 1633 |